2023-11-21 アメリカ合衆国・フロリダ大学(UF)

・ UF と NVIDIA が、医師の診断書を生成する大規模言語モデルを開発。AI による革新的な効率性を通じた、ヘルスケア従事者支援の可能性が期待できる。

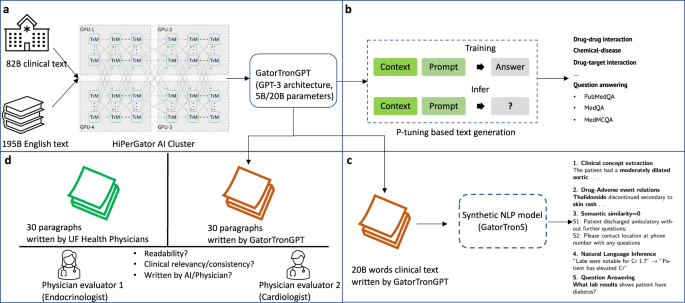

・ ChatGPT と同様の働きをする新モデルの GatorTronGPT をベースに、NVIDIA 提供のスーパーコンピューター「HiPerGator」を訓練して診療録を生成。GatorTronTM モデルは Hugging Face(オープンソース AI ウェブサイト)から 43 万回以上ダウンロードされている、臨床研究に特化した唯一のモデル。

・ 自然言語モデルは標準的な著述や会話に適しているが、診療録に関しては患者のプライバシーや専門性の高さといった追加的な課題がある。デジタル診療録は、Google での検索や Wikipedia による共有が不可能。

・ この課題に対処するため、UF 診療録のうち 820 億件の医療用語を保持しながら 2 百万人分の個人情報を削除し、このデータセットを別の 1,950 億ワードのセットと組み合わせて GatorTronGPT モデルを訓練し、GPT-3(ニューラルネットワークアーキテクチャ)で医療データを分析した。

・ これにより、医師の書く診断書に極めて近い臨床文書の GatorTronGPT による生成が可能に。医師作成の診断書と AI プログラム生成の診断書について、医師による判別の正解率は僅か 49%とほとんど差異のないことがわかった。

・ 医療用 GPT の活用方法の一つは、煩わしい文書作成作業を AI による診断書の記録・文字化で代替すること。UF は、このソフトウェアの商業化を進めるイノベーションセンターを有している。

・ 本研究には、患者中心アウトカム研究所(PCORI)、米国立がん研究所(NCI)および米国立老化研究所(NIA)が資金を提供した。

URL: https://ufhealth.org/news/2023/medical-ai-tool-from-uf-nvidia-gets-human-thumbs-up-in-first-study#for-the-media

<NEDO海外技術情報より>

関連情報

npj Digital Medicine 掲載論文(フルテキスト)

A study of generative large language model for medical research and healthcare

URL: https://www.nature.com/articles/s41746-023-00958-w

Abstract

There are enormous enthusiasm and concerns in applying large language models (LLMs) to healthcare. Yet current assumptions are based on general-purpose LLMs such as ChatGPT, which are not developed for medical use. This study develops a generative clinical LLM, GatorTronGPT, using 277 billion words of text including (1) 82 billion words of clinical text from 126 clinical departments and approximately 2 million patients at the University of Florida Health and (2) 195 billion words of diverse general English text. We train GatorTronGPT using a GPT-3 architecture with up to 20 billion parameters and evaluate its utility for biomedical natural language processing (NLP) and healthcare text generation. GatorTronGPT improves biomedical natural language processing. We apply GatorTronGPT to generate 20 billion words of synthetic text. Synthetic NLP models trained using synthetic text generated by GatorTronGPT outperform models trained using real-world clinical text. Physicians’ Turing test using 1 (worst) to 9 (best) scale shows that there are no significant differences in linguistic readability (p = 0.22; 6.57 of GatorTronGPT compared with 6.93 of human) and clinical relevance (p = 0.91; 7.0 of GatorTronGPT compared with 6.97 of human) and that physicians cannot differentiate them (p < 0.001). This study provides insights into the opportunities and challenges of LLMs for medical research and healthcare.