2025-05-01 マサチューセッツ工科大学(MIT)

<関連情報>

- https://news.mit.edu/2025/making-ai-models-more-trustworthy-high-stakes-settings-0501

- https://dmshanmugam.github.io/pdfs/CVPR_2025_TTA_CP.pdf

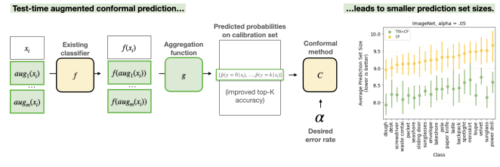

テスト時間増大はコンフォーマル予測における効率を改善する Test-time augmentation improves efficiency in conformal prediction

Divya Shanmugam, Helen Lu, Swami Sankaranarayanan, John Guttag

Abstract

A conformal classifier produces a set of predicted classes and provides a probabilistic guarantee that the set includes the true class. Unfortunately, it is often the case that conformal classifiers produce uninformatively large sets. In this work, we show that test-time augmentation (TTA)–a technique that introduces inductive biases during inference– reduces the size of the sets produced by conformal classifiers. Our approach is flexible, computationally efficient, and effective. It can be combined with any conformal score, requires no model retraining, and reduces prediction set sizes by 10%-14% on average. We conduct an evaluation of the approach spanning three datasets, three models, two established conformal scoring methods, different guarantee strengths, and several distribution shifts to show when and why test-time augmentation is a useful addition to the conformal pipeline.